L’IA pose un certain nombre de défis éthiques. Par exemple, la manipulation du comportement humain par les algorithmes, la violation de la vie privée via le stockage et l’utilisation de données personnelles. Le manque de véracité des systèmes d’IA générative ou encore les discriminations algorithmiques sont d’autres menaces notables.

Lewis Griffin est chercheur en informatique à l’University College London (UCL). Pour lui, « l’expansion des capacités des technologies basées sur l’Intelligence Artificielle (IA) s’accompagne d’une augmentation de leur potentiel d’exploitation criminelle». Il répartit chacune des menaces identifiées de l’IA. Celui-ci les met dans une liste les classant par ordre de dommages potentiels et de facilité de mise en œuvre. Le but étant d’évaluer le rapport de risques en matière d’utilisation criminelle.

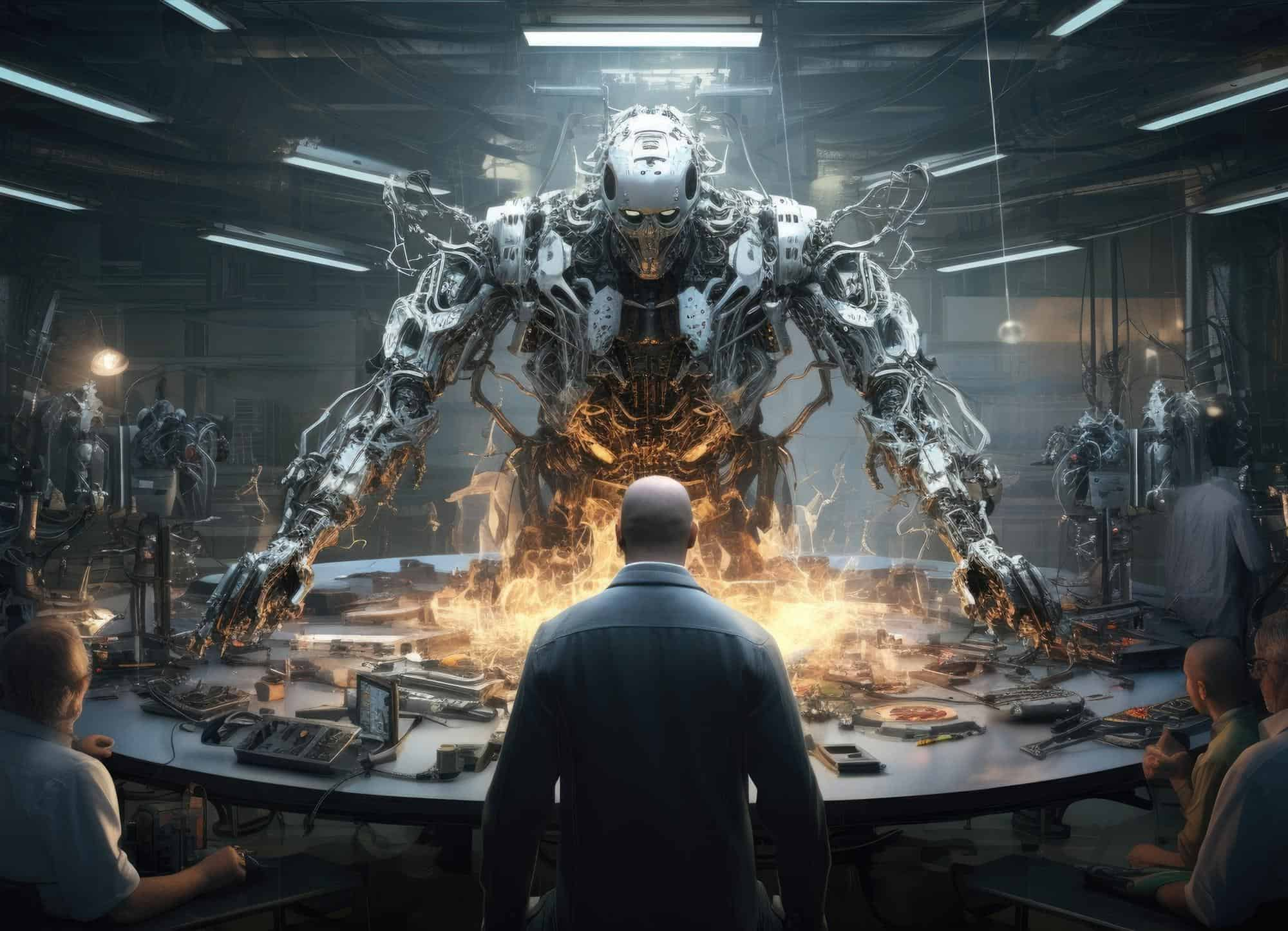

L’IA flirte avec la manipulation

La désinformation représente l’une des plus sérieuses menaces de l’IA. En cause : son potentiel d’influence, à l’échelle politique comme sociétale. Les fake news circulant sur les réseaux sociaux et l’utilisation de deepfake participent de cette désinformation. Par la force de travail qu’elle représente, l’IA constitue le meilleur moyen de générer et faire circuler un grand nombre de fausses informations. Celles-ci sont créées de sorte à paraître crédibles et circuler efficacement dans un court laps de temps.

De nos jours, il existe de nombreux outils d’IA capables de réaliser ce genre de tâches de façon autonome et spontanée. Certains sont assez compétents pour rédiger de faux articles de presse. GPT2, par exemple, qui n’est autre que le « petit frère » de ChatGPT. Il serait capable de créer des « deepfake for text» et de les partager lui-même sur les réseaux sociaux. De toute évidence, cette génération massive de contenus « plausibles » peut avoir un immense impact. Lorsqu’une publication « inonde » internet (flooding) à grande échelle, elle est bien souvent perçue comme véridique par l’opinion publique, assurée d’être à l’abri de toute influence.

L’IA a le pouvoir de manipuler l’information comme sa perception. S’armer des bons outils pour apprendre à reconnaître son produit est une clé de l’indépendance intellectuelle.